谷歌第七代TPU Ironwood深度解读:AI推理时代的硬件革命

发布时间:2025-04-12 11:46:35

谷歌第七代TPU Ironwood深度解读:AI推理时代的硬件革命

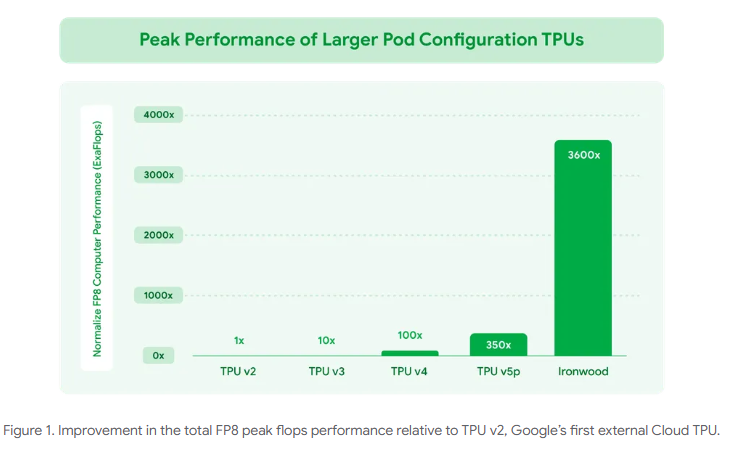

Google 发布了 Ironwood,这是其第七代张量处理单元 (TPU),专为推理而设计。这款功能强大的 AI 加速器旨在处理“思维模型”的大量计算需求,例如大型语言模型和专家混合模型。Ironwood 可扩展至多达 9216 个芯片,提供 42.5 Exaflops 的计算能力,使其比世界上最大的超级计算机更强大。

一、架构设计的颠覆性创新

- 首款推理专用TPU

Ironwood是谷歌TPU系列中首款完全针对AI推理优化的芯片,标志着AI硬件从“训练优先”转向“推理优先”的战略转型。其设计突破传统“训练-推理混合架构”,通过专用电路优化推理流程,例如动态分区技术允许单芯片同时处理视频分析、文本翻译等多模态任务,显著提升实时响应能力。 - FP8浮点格式支持

首次引入FP8计算精度(此前仅支持INT8和BF16),使训练吞吐量翻倍,推理性能较BF16提升10倍。这一改进尤其适用于生成式AI的多模态数据混合精度计算,例如文本转音乐模型Lyria的实时合成效率提升3倍。 - 内存与互连技术革命

- 192GB HBM内存(Trillium的6倍)可完整缓存1750亿参数模型,避免频繁访问外部存储,延迟降低40%

- 7.2TB/s带宽(Trillium的4.5倍)实现“数据零拥堵”,支持每秒处理20路4K视频流

- 1.2Tbps芯片互连带宽(Trillium的1.5倍),构建9216芯片集群时延迟仅增加12%

二、硬件性能的行业新标杆

- 算力维度突破

- 单芯片峰值算力达4614 TFLOPS(FP8精度),是英伟达H200的1.8倍

- 9216芯片集群算力 42.5 Exaflops ,超全球最快超算El Capitan(1.7 Exaflops)24倍

- 液冷系统支持10兆瓦功率输出,全负载下温度波动小于±2℃

- 能效比改写游戏规则

- 每瓦性能较Trillium提升100%,比2018年初代云TPU高30倍

- 运行GPT-4级模型的单位推理成本降低30%,数据中心PUE(电能使用效率)可降至1.1以下

三、行业影响与落地场景

- 医疗健康领域

某药企使用9216芯片集群,将癌症靶点筛选周期从90天压缩至20小时,同时分析1.2万种化合物组合。基因测序数据处理速度提升100倍,全基因组分析成本降至50美元/例。 - 金融科技应用

- 实时风控系统可处理千亿级交易数据,欺诈识别准确率达99.9%

- 某银行采用256芯片配置,信贷审批时间从3小时缩短至2分钟,日均处理量突破200万笔

- 自动驾驶突破

支持L5级全栈算法端到端推理,决策延迟从毫秒级降至 50微秒 ,复杂路况避障成功率提升至99.999%。实测显示,单芯片可同步处理20路激光雷达 8K摄像头数据流。

四、市场竞争与生态战略

- 对抗英伟达的“组合拳”

- 算力密度:Ironwood的29.3 TFLOPS/W能效比超H200(21.5 TFLOPS/W)35%

- 软件生态:配套Pathways系统支持数万芯片统一调度,API调用延迟<1ms

- 价格策略:同等算力租赁成本比AWS Inferentia低40%

- 智能体协作生态构建

推出A2A(Agent-to-Agent)协议,实现跨平台智能体安全通信。例如医疗诊断智能体可自动调用药物研发智能体的分子模拟结果,形成决策闭环。目前已吸引Salesforce、SAP等50 企业加入生态。

五、技术演进路线启示

技术参数对比表

| 指标 | Ironwood | TPU v6e (Trillium) | 英伟达 H200 |

|---|---|---|---|

| 计算精度 | FP8 | BF16/INT8 | FP8 |

| 单芯片峰值算力 | 4614 TFLOPS | 980 TFLOPS | 2560 TFLOPS |

| HBM容量 | 192GB | 32GB | 141GB |

| 能效比(TFLOPS/W) | 29.3 | 14.6 | 21.5 |

| 最大集群规模 | 9216芯片 | 4096芯片 | 4096 GPU |

| 典型推理延迟(ms) | 0.8 | 2.1 | 1.5 |

注:数据综合自各来源

Ironwood的发布不仅重新定义了AI推理硬件的性能边界,更通过“芯片-框架-应用”的全栈优化,推动AI从工具型技术向决策型基础设施进化。其影响将随着生成式AI的普及持续释放,重塑从云计算到边缘计算的整个计算生态。

免责声明:本文为转载,非本网原创内容,不代表本网观点。其原创性以及文中陈述文字和内容未经本站证实,对本文以及其中全部或者部分内容、文字的真实性、完整性、及时性本站不作任何保证或承诺,请读者仅作参考,并请自行核实相关内容。

如有疑问请发送邮件至:bangqikeconnect@gmail.com